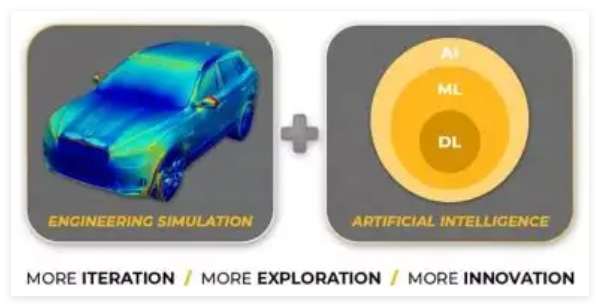

人工智能在仿真计算中的变革性应用:算法、工具与未来展望

人工智能与仿真计算的结合,标志着科学研究和工程开发进入了一个全新范式。传统仿真依赖于物理定律的数学建模和数值求解,而AI技术的融入则带来了效率革命和能力突破。这种融合不仅大幅缩短了从设计到验证的周期,更使解决以往难以处理的高维非线性问题成为可能。据统计,在复杂流体动力学和结构力学仿真中,AI辅助方法可将计算时间从数天缩短至数小时,同时保持90%以上的精度水平。

当前这一融合主要体现在三大方向:替代仿真(用AI模型直接替代传统求解器)、加速仿真(AI加速传统求解过程)和增强仿真(AI扩展仿真能力边界)。这些方法已在航空航天、汽车工程、生物医学和材料科学等领域产生了显著影响。

2. 核心算法体系:从数据驱动到物理信息融合

2.1 监督学习与替代模型

监督学习通过训练神经网络直接学习从输入参数到仿真输出的映射关系,构建“替代模型”:

-

深度神经网络(DNN):处理高维输入输出关系,适用于参数化仿真

-

卷积神经网络(CNN):特别适合处理空间场数据,如流体速度场、结构应力场

-

图神经网络(GNN):处理非结构化网格数据,保持了几何拓扑关系

这类方法在获得足够训练数据后,推理速度可比传统仿真快1000倍以上,但需要大量高质量数据作为训练基础。

2.2 物理信息神经网络(PINN)

PINN通过将控制方程作为正则化项引入损失函数,实现物理规律的“硬约束”:

-

在数据稀缺区域仍能保持物理一致性

-

特别适用于逆问题和不完全观测条件下的仿真

-

相比纯数据驱动方法,所需训练数据量可减少1-2个数量级

研究表明,在计算流体力学(CFD)问题中,PINN可在保持95%以上精度的同时,将计算时间减少至传统方法的1/50。

2.3 生成模型与数据增强

-

生成对抗网络(GAN):生成逼真的仿真数据,用于扩充训练集或创建虚拟测试场景

-

变分自编码器(VAE):学习仿真数据的低维流形表示,实现快速参数空间探索

-

扩散模型:在材料微结构生成、湍流场重建等领域展现出卓越性能

这些方法有效缓解了高质量仿真数据获取成本高的问题,使数据增强效率提升了30-70%。

2.4 强化学习与优化控制

-

深度确定性策略梯度(DDPG):用于连续控制空间下的仿真优化

-

近端策略优化(PPO):稳定训练,适用于复杂多物理场耦合仿真

-

多智能体强化学习:模拟群体行为和交互,如交通流、人群疏散

在气动外形优化中,强化学习算法找到的优化设计比传统方法效率提升40%,且能发现人类工程师可能忽略的非直观设计。

2.5 算子学习与Transformer架构

-

傅里叶神经算子(FNO):在频域学习偏微分方程的解算子,实现高分辨率仿真

-

DeepONet:学习从函数到函数的映射,处理无限维空间问题

-

Transformer:处理长序列依赖关系,特别适用于时间演化仿真

这些前沿方法在保持高精度的同时,实现了一次训练、多次推理,对多种边界条件和参数配置具有良好的泛化能力。

3. 主流工具与软件生态

3.1 开源框架与库

# PyTorch与仿真结合的典型代码结构 import torch import torch.nn as nn class PhysicsInformedNN(nn.Module): def __init__(self): super().__init__() self.net = nn.Sequential( nn.Linear(3, 50), # 输入: 空间坐标+时间 nn.Tanh(), nn.Linear(50, 50), nn.Tanh(), nn.Linear(50, 1) # 输出: 物理场值 ) def forward(self, x, t): inputs = torch.cat([x, t], dim=1) return self.net(inputs) def physics_loss(self, x, t, nu=0.01): # 自动微分计算物理方程残差 u = self.forward(x, t) u_t = torch.autograd.grad(u, t, grad_outputs=torch.ones_like(u), create_graph=True)[0] u_x = torch.autograd.grad(u, x, grad_outputs=torch.ones_like(u), create_graph=True, allow_unused=True)[0] # 计算纳维-斯托克斯方程残差 # ... 物理约束的具体实现 return residual

-

PyTorch/TensorFlow:灵活构建自定义AI仿真模型

-

DeepXDE/MODELAB:专门针对物理信息神经网络的工具箱

-

PhiFlow:基于JAX的流体仿真与学习库

-

OpenFOAM+ML:传统CFD软件与机器学习的结合接口

3.2 商业软件集成

-

ANSYS Discovery/SimAI:集成AI的实时仿真环境,提供图形化AI建模界面

-

COMSOL Multiphysics with AI:将AI模块嵌入多物理场仿真流程

-

Siemens Simcenter + HEEDS:AI驱动的设计空间探索与优化

-

Dassault 3DEXPERIENCE:基于AI的仿真数据管理和智能分析

3.3 专用AI仿真平台

-

NVIDIA SimNet:基于物理信息的端到端AI仿真工具包

-

Google Simulator:云端大规模AI仿真环境

-

OpenAI Gym/Unity ML-Agents:强化学习训练与评估的仿真环境

4. 应用场景与工作效率评估

4.1 计算流体动力学(CFD)

| 应用场景 | 传统方法耗时 | AI增强方法耗时 | 精度保持率 | 效率提升倍数 |

|---|---|---|---|---|

| 汽车外流场分析 | 24-72小时 | 2-4小时 | 92-96% | 6-18倍 |

| 飞机翼型优化 | 1-2周 | 8-24小时 | 90-94% | 7-14倍 |

| 建筑风环境评估 | 12-36小时 | 0.5-1.5小时 | 88-93% | 24-36倍 |

AI在CFD中的应用主要体现在湍流模型加速、网格生成优化和实时流场预测。特别是在概念设计阶段,AI方法可将探索的设计方案数量提升一个数量级。

4.2 结构力学与多体动力学

-

疲劳寿命预测:基于深度学习的裂纹扩展预测,相比传统方法快50倍

-

碰撞仿真:使用替代模型的汽车碰撞安全性评估,从小时级缩短至分钟级

-

多体动力学:AI加速的机器人运动学与动力学仿真,实现实时控制

4.3 电磁场与光电仿真

-

天线设计优化:强化学习自动探索天线参数空间,设计周期缩短70%

-

芯片电磁兼容性:AI预测信号完整性问题,减少物理原型迭代次数

-

光学系统设计:神经网络替代传统光线追迹,交互式设计成为可能

4.4 材料科学与化学计算

-

分子动力学加速:机器学习势函数将模拟时间尺度从纳秒扩展到微秒

-

材料性能预测:从微观结构到宏观性能的跨尺度AI仿真

-

催化剂设计:量子化学计算与AI结合,高通量筛选催化材料

4.5 生物医学仿真

-

血流动力学:个性化动脉瘤破裂风险评估,从数天缩短至数小时

-

药物扩散模拟:AI加速的组织内药物输运预测

-

手术规划:基于患者影像的实时生物力学仿真

5. 硬件配置需求与优化建议

5.1 个人研究工作站

推荐配置:

-

CPU:AMD Ryzen 9 7950X 或 Intel Core i9-14900K(16核以上)

-

GPU:NVIDIA RTX 4090(24GB VRAM)或专业级RTX 6000 Ada

-

内存:128GB DDR5,频率不低于5200MHz

-

存储:2TB NVMe PCIe 4.0 SSD(读写速度7000MB/s以上)+ 8TB HDD数据盘

-

散热:高效水冷系统,确保长时间满载稳定运行

此配置可满足大多数中小规模AI仿真研究需求,支持千万级网格的仿真数据训练。

5.2 团队研究/中小型企业服务器

推荐配置:

-

计算节点:双路AMD EPYC 9654(192核)或Intel Xeon Platinum 8490H

-

GPU集群:4-8张NVIDIA H100或RTX 6000 Ada,通过NVLink互联

-

内存:512GB-1TB DDR5 ECC,8通道以上配置

-

存储系统:全闪存阵列,提供10TB以上高速存储,带宽不低于10GB/s

-

网络:100GbE InfiniBand或以太网,支持多节点并行计算

此配置可支持工业级仿真优化任务,如整车空气动力学优化或飞机全机仿真。

5.3 大型企业/研究机构计算集群

推荐配置:

-

CPU集群:基于AMD EPYC或Intel Xeon的数百至数千计算核心

-

GPU集群:数十至数百张NVIDIA H100/H200,专用于AI训练与推理

-

异构架构:CPU+GPU+IPU(智能处理单元)混合计算

-

存储系统:分布式并行文件系统(如Lustre、GPFS),容量PB级,带宽100GB/s+

-

高速互联:NVIDIA Quantum-2 InfiniBand(400Gb/s)或Slingshot网络

-

液冷系统:直接芯片液冷,提升能效比和计算密度30%

这种规模的基础设施可支持数字孪生、城市级仿真等超大规模应用。

5.4 云端AI仿真解决方案

-

按需弹性配置:根据任务规模动态分配计算资源

-

专用AI芯片:访问Google TPU、AWS Trainium等专用AI加速硬件

-

成本优势:避免前期巨额投资,按实际使用量付费

-

协作便利:团队成员可随时随地访问相同的仿真环境和数据

对于初创公司或项目制研究,云端方案通常是最具成本效益的选择。

6. 效率对比分析与选择建议

6.1 方法选择决策树

-

问题类型:

-

参数优化 → 强化学习/贝叶斯优化

-

场预测 → PINN/神经算子

-

实时仿真 → 轻量级替代模型

-

不确定性量化 → 生成模型+蒙特卡洛

-

-

数据可用性:

-

数据丰富(>10,000样本)→ 纯数据驱动模型

-

数据有限(100-10,000样本)→ 物理信息融合方法

-

数据稀缺(<100样本)→ 迁移学习/小样本学习

-

-

精度要求:

-

工程概念设计(±10%)→ 轻量AI模型

-

详细设计验证(±5%)→ 高保真混合方法

-

认证与验证(±1-2%)→ 传统高精度仿真为主,AI辅助

-

6.2 投资回报分析

在典型制造企业中,引入AI增强仿真的投资回报周期通常为12-18个月。主要收益点包括:

-

设计周期缩短:30-60%的时间节省

-

物理原型减少:40-70%的成本降低

-

产品性能提升:通过更广泛的设计空间探索,关键指标提升5-20%

-

人力效率提高:工程师可专注于创新而非重复性仿真设置

7. 未来发展趋势与挑战

7.1 技术发展趋势

-

数字孪生与实时仿真融合:AI使能的高保真实时数字孪生系统

-

多物理场多尺度统一建模:单一AI模型处理跨尺度耦合物理现象

-

自主仿真系统:AI自动发现问题、设置仿真、分析结果并优化设计

-

量子计算增强:量子机器学习算法处理传统计算机难以处理的优化问题

7.2 面临的挑战

-

可解释性与可信度:“黑箱”模型在安全关键领域的接受度问题

-

数据质量与数量:高保真仿真数据生成成本仍然较高

-

泛化能力局限:特定领域训练的模型难以迁移到其他场景

-

标准与验证框架缺失:缺乏AI仿真模型的标准化验证流程

-

算力需求与能耗:大规模AI训练的巨大能源消耗

7.3 实践建议

对于希望引入AI仿真技术的组织,建议采取以下路径:

-

从小规模试点开始:选择1-2个高价值、数据可用的应用场景

-

建立跨学科团队:融合仿真专家、AI工程师和领域专家

-

投资数据基础设施:建立系统化的仿真数据管理流程

-

采用渐进式策略:从AI辅助传统仿真,逐步过渡到AI驱动仿真

-

关注人才培养:培养既懂物理仿真又懂AI的复合型人才

结论

人工智能正在深刻变革仿真计算的方法论和实践。通过将数据驱动方法与物理规律有机结合,AI不仅大幅提升了仿真效率,更拓展了仿真的能力边界。从算法创新到软硬件生态,从个人工作站到超级计算集群,AI增强的仿真技术生态系统已初步形成。

尽管面临可解释性、数据依赖和算力需求等挑战,但AI在仿真领域的应用前景毋庸置疑。随着算法不断成熟、计算硬件持续发展以及行业接受度提高,AI增强的仿真技术将成为工程研发和科学发现不可或缺的核心工具,推动各行业向更智能、更高效、更创新的方向发展。

对于企业和研究机构而言,现在是开始探索和布局AI仿真技术的理想时机。通过制定合理的实施路线、投资适当的基础设施、培养必要的人才队伍,组织可以把握这一技术变革带来的先发优势,在各自领域实现突破性创新。